Evaluation von Reinforcement-Learning für die Entwicklung von Investment-Strategien

- Degree programme: MAS Data Science

- Author: Marc Slavin

- Year: 2021

Kann durch Reinforcement-Learning eine erfolgreiche Strategie für das Investieren am Aktienmarkt entwickelt werden? Auf Basis welcher Eingangssignale kann eine AI befähigt werden als Investor zu agieren und welche Kriterien muss ein Environment erfüllen, so dass der Agent sinnvoll für diese Aufgabe trainiert werden kann.

Ausgangslage

Die Herausforderung besteht zunächst darin, sinnvolle Eingangssignale zu evaluieren, auf Basis deren ein Reinforcement-Learning Agent grundsätzlich sinnvolle Entscheidungen treffen kann. Hierfür kommen Fundamentaldaten der Geschäftsberichte, sowie betriebswirtschaftliche Kennzahlen in Frage. Auch können Modelle für Zeitreihen, wie ARIMA oder Moving-Averages, verwendet werden. Zudem muss eine Entscheidung getroffen werden, welche Reinforcement-Learning Methode für die vorliegende Aufgabenstellung die sinnvollste ist. Es ist weiterhin zu überlegen, wie die Ergebnisse, welche durch den Agenten erzielt werden, kritisch bewertet werden können.

Ziele

Das Ziel ist eine Strategie zu entwickeln, welche grundsätzlich Gewinne erzielt und erfolgreicher ist als eine einfache Kaufen- und Halten Strategie. Hierfür müssen sinnvolle Signale selektiert werden. Auch soll untersucht werden, welche Eigenschaften eines Kursverlaufs den Erfolg einer durch RL trainierten Strategie, begünstigen. Auch sollen die Besonderheiten von Zeitreihen als Environment untersucht werden.

Resultat

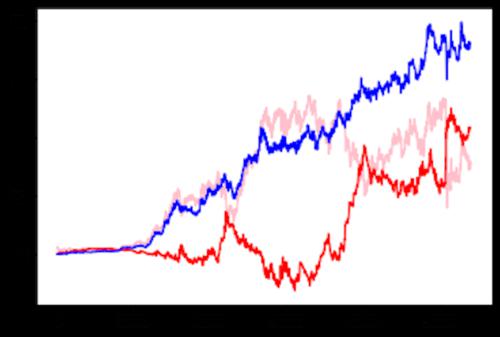

Zunächst wurde, nach einer Voruntersuchung von ARIMA Modellen, für die Prognose von Aktienkursen, von einer weiteren Evaluierung abgesehen, da sich keine wesentliche Eignung für das Erzeugen von Kaufsignalen feststellen liess. Im nächsten Schritt wurden Moving-Average Signale für das Trainieren eines RL-Agenten verwendet. In einem ersten Test, war die Strategie erfolgreich, konnte aber keine höheren Gewinne erzielen, als eine einfache Kaufen- und Halten Strategie. Aus diesem Grund wurden Moving-Average Strategien auf alle ca. 6000 Aktien untersucht. Das Ergebnis war, dass es charakteristische Kursverläufe gibt, für die sich diese Strategien besser oder schlechter eignen. Weiterhin wurde festgestellt, dass um Overfit-Effekte zu verhindern, die Anzahl der Signale begrenzt werden muss. Das finale Resultat ist, dass für den Erfolg, die Auswahl der Aktie (auf Basis von Trend, Varianz, etc.), sowie die Selektion der Features wesentlich sind. Insofern diese Selektion stattfindet, kann der Agent einen wesentlich höheren Gewinn als denjenigen der Kaufen- und Halten Strategie, erzielen.

Zukünftige Arbeiten

In weiterführenden Arbeiten müssen die Charakteristiken derjenigen Kursverläufe tiefer analysiert werden, bei denen Reinforcement-Learning mit Moving-Averages, erfolgreich angewendet werden kann. Dies könnte zum Beispiel anhand von Clustering-Verfahren oder Convolutional Neuronal Networks geschehen. Auch sollte über die Verwendung eines Multi-Agenten Systems nachgedacht werden, um Strategien zu entwickeln, welche auf verschiedenen Zeitabschnitten der Daten trainiert werden, um dann im Kollektiv abzustimmen.